Varias veces en los últimos meses he publicado notas acerca del efecto que tiene el uso de inteligencia artificial en la difusión de noticias. La mayoría de esos comentarios expresaba una alarma frente a lo que ocurre. Por eso, el trabajo publicado esta última semana por un grupo de medios europeos viene a confirmar la preocupación que se ha generado y de la que participo.

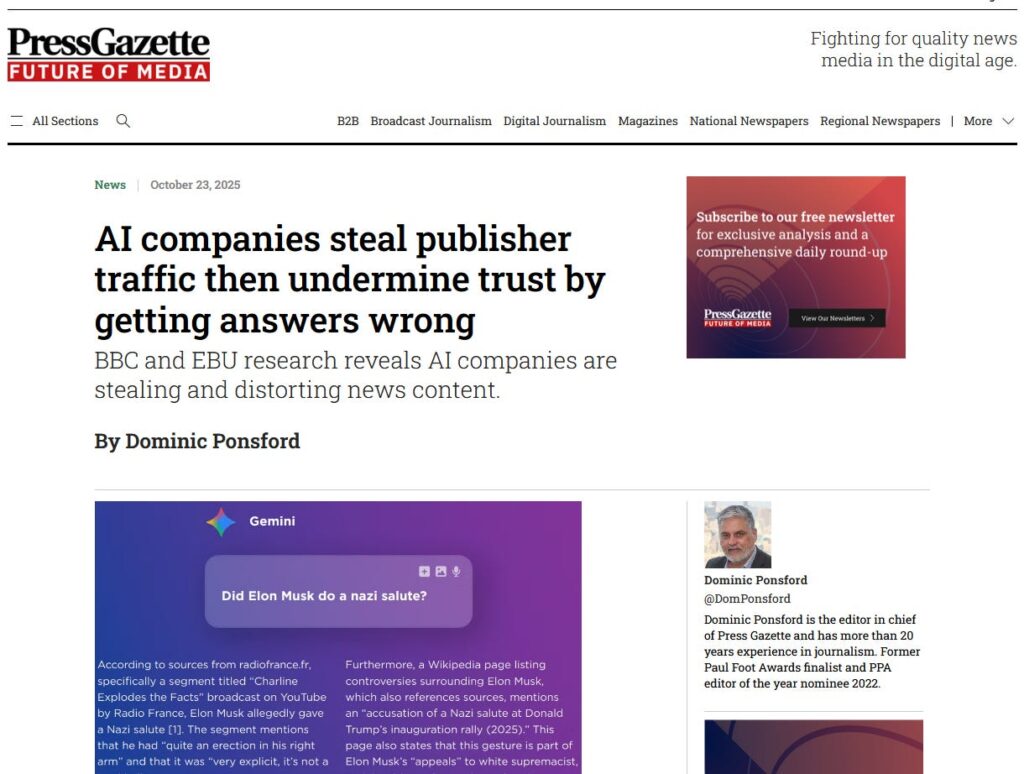

Varios medios se encargaron de la divulgación de sus hallazgos, aunque me gustó mucho el título de PressGazette que parafraseo en este artículo y que se muestra en la siguiente imagen:

El estudio revisa la manera en que cuatro modelos de inteligencia artificial (ChatGPT, Copilot, Gemini y Perplexity) muestran contenido de noticias a partir de la información de 22 medios públicos en Europa, Estados Unidos y Canadá. Utilizando una metodología que desarrolló BBC a comienzos de año, se revisaron 2.709 mil respuestas proporcionadas por asistentes que usan IA y que toman como referencias las notas publicadas por 22 medios que publican en 14 idiomas diferentes en 18 países. La tarea fue hecha por 271 periodistas.

Lo que se mide

Lo interesante del documento es que incluye su metodología, gracias a lo cual podemos entender qué evaluaron en cada caso. Las categorías usadas para revisar fueron:

- Precisión: para ver qué tan cercana era la respuesta respecto de lo publicado.

- Fuentes: para revisar si se indica de dónde se obtuvo la información.

- Hacer distinción entre opiniones y hechos: para determinar lo que corresponde a datos reales.

- Editorialización: descubre si se agregan palabras que no figuran en el original.

- Contexto: si se entrega información suficiente a través una respuesta completa que no genere confusión.

Los resultados

En las conclusiones del trabajo se muestra que el 45% de las respuestas entregadas por la IA tiene algún tipo de problema en alguna de las categorías de la lista anterior. A eso se agrega una frase muy representativa del estado actual de la tecnología: los errores son sistémicos y están en la naturaleza de la inteligencia artificial.

Se agrega que “los temas relevantes están en niveles preocupantes y no se puede decir que estos asistentes sean una fuente de información confiable acerca de las noticias”.

Finaliza planteando que “una proporción importante de las respuestas de los asistentes no cumple con criterios básicos tales como precisión y entrega de contexto adecuado, ambas cosas que son valores editoriales esenciales para un periodismo de calidad y el contenido de las noticias”.

Pese a eso, el trabajo realizado ofrece una luz de esperanza dado que se incluye un toolkit que funciona como una lista de tareas que permitirán a futuro mejores resultados, siempre que los desarrolladores de los asistentes con IA se hagan cargo de las recomendaciones.

Por ahora, el llamado a la IA respecto de su rol para difundir noticias es: siga participando.